Publicado

- 4 min tiempo de lectura

Mejora tu IA con Generación Aumentada por Recuperación (RAG)

Hola, aquí estoy un viernes más con un poco de Machine Learning,

Hoy se me ha ocurrido que podía ser interesante explicar la Generación Aumentada por Recuperación (RAG). Ya que tiene muchas ventajas para las empresas.

El término está muy de moda, y básicamente como ya sabes, se trata de mejorar la respuesta de un LLM (ChatGPT es el más conocido y gpt-4o la última y más avanzada versión accesible mediante una API (para resumir, mediante programación). Esta mejor respuesta que se consigue con RAG es gracias a realizar las consultas al LLM con el contexto de la información de tu empresa o proyecto. Es como crear un asistente virtual especializado en tus documentos o empresa. Este enfoque promete revolucionar la forma en que nuestras IA responden a las consultas, garantizando que las respuestas sean más precisas y alineadas con nuestras necesidades o las de nuestros clietes.

Desafíos de la IA Generativa

Yo siempre soy honesto, y como sabes, aunque las IA generativas son impresionantes, tienen sus pegas. Uno de los mayores problemas es asegurar que las respuestas sean precisas y adecuadas a la marca. Imagínate que tienes una IA que responde a tus clientes, pero sus respuestas no siempre son exactas o, peor aún, no reflejan los valores de tu marca. ¡Un desastre total! Aquí es donde RAG entra en juego.

Cómo RAG Mejora la Precisión

RAG, o Generación Aumentada por Recuperación, es una técnica que permite a los modelos de lenguaje grande (LLM) acceder a información específica y actualizada. ¿El resultado? Respuestas que son aproximadamente un 43% (según este paper) más precisas que las generadas solo por LLMs sin el contexto particular.

En otras palabras, RAG actúa como un asistente personal para nuestra IA, proporcionándole los datos más relevantes justo cuando los necesita.

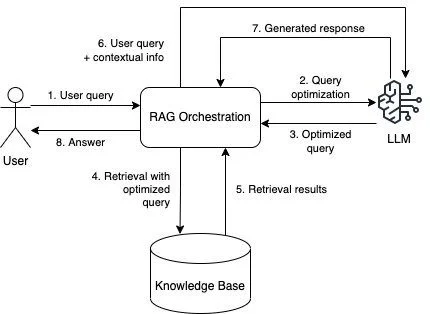

Funcionamiento de RAG

Entonces, ¿cómo funciona RAG? Pues explicado de forma sencilla, es algo así:

- Consulta del usuario: El usuario introduce una pregunta o solicitud que necesita ser respondida.

- Optimización de la consulta: La IA toma la pregunta del usuario y la optimiza para una mejor búsqueda.

- Consulta optimizada: La pregunta ajustada se prepara para buscar información relevante.

- Recuperación de información: Busca en una base de conocimiento específica y actualizada.

- Resultados de la recuperación: Los datos relevantes y precisos se recuperan de la base de conocimiento.

- Consulta del usuario + información contextual: La consulta inicial del usuario se combina con los resultados recuperados para proporcionar un contexto completo.

- Generación de respuesta: El LLM utiliza esta información para generar una respuesta en lenguaje natural.

- Respuesta: La respuesta generada se envía de vuelta al usuario, proporcionando una solución precisa y contextualizada a su consulta.

Esta metodología no solo mejora la precisión, sino que también asegura que las respuestas estén alineadas con la información más reciente y relevante.

Problemas Clave al Implementar RAG

Implementar RAG no es una cosa sencilla. Te dejo una lista de problemas clave que debemos considerar:

- Intención del Usuario: Es crucial analizar y categorizar correctamente la intención del usuario para recuperar información relevante.

- Selección y Preparación de Contenidos: Los datos deben ser precisos y actualizados. Esto incluye metadatos y la eliminación de información sensible.

- Recuperación de Información: Es vital elegir los mecanismos de búsqueda adecuados (léxica y semántica) para asegurar que las respuestas sean pertinentes y exactas.

Preparación de los Datos

La llamada curación de contenidos, es esencial. La calidad de las respuestas depende directamente de la calidad y relevancia de la información en la base de conocimiento. Esto implica extraer metadatos y dividir contenido largo en secciones manejables (chunks), además asegurando el cumplimiento de las directrices de privacidad.

Mecanismos de Recuperación de Información

La optimización del acceso a los datos es otra pieza clave. Esto se logra dividiendo el contenido en secciones enfocadas y eligiendo entre búsquedas léxicas y semánticas según las necesidades del usuario. Además, analizar las consultas típicas de los usuarios ayuda a estructurar mejor la base de conocimiento.

Maximizar el Valor de RAG

Para maximizar el valor de RAG, es esencial identificar problemas de negocio específicos, como responder preguntas de servicio al cliente de manera rápida y personalizada. También es importante tomarse el tiempo para categorizar las intenciones de usuario y curar el contenido adecuadamente.

Es decir, la Generación Aumentada por Recuperación es una herramienta muy buena que, combinada con el esfuerzo humano, puede transformar la manera en que nuestras IA responden a las consultas. Al entender y aplicar RAG, podemos ofrecer respuestas más precisas y significativas, mejorando significativamente la experiencia del usuario. Toda una ventaja al alcance de nuestras empresas y PYMEs

Nos leemos pronto y, hasta entonces, que disfrutes de estos días de primavera de los amigos y la familia.

Un fuerte abrazo, Raúl Jáuregui de Mindfulml.vialabsdigital.com 🌟📉💻

Artículos relacionados

SEO en la era de la IA: por qué ahora necesitas también GEO

Ahora tu agente inteligente te habla (y no interrumpe)

¿Qué hago primero hoy? Cómo prioriza el agente tus tareas

Ver 27 artículos más

- Cómo conectar tu agente con Notion y empezar a priorizar tu día

- Tu secretario inteligente: un agente que organiza tu día y te habla por Telegram

- Semántica en la inteligencia artificial: word embeddings en NLP

- Eventos del año: Google I/O 2024 y OpenAI Spring Update

- 🦙 LLaMA 3 ha llegado: Impulso para los Proyectos Open Source

- ¡A Freno Limpio! Tu Coche Pronto Leerá Tu Mente

- Google Cloud Next24: Google se suma a la carrera de los Agentes IA

- El Sesgo y la Varianza en el Machine Learning

- Redes Neuronales: Más Allá de los Fundamentos del Machine Learning

- 🤖 IA vs. Machine Learning vs. Deep Learning

- Explicabilidad vs. Interpretabilidad en IA

- Tendencias en Ciencia de Datos

- Batalla entre los Grandes Modelos de Lenguaje (LLM)

- La Magia del ML en los Pequeños Cultivos de la India

- Descubriendo el futuro: Una red neuronal que supera a los doctores 🏥✨

- Interpretabilidad vs. Explicabilidad: Desvelando el Enigma del Machine Learning

- ¿Software 2.0? ¡Descubre qué es! 🧑💻

- El futuro del ML es local, y va a revolucionarlo todo 📍

- La Revolución Antibiótica gracias a la Inteligencia Artificial

- 🚀 ¡Novedades IA: Gemini Pro y ChatGPT está perezoso! 🤖

- ¡El Competidor de ChatGPT ya está aquí! ¿Estás Listo para Gemini?

- ⚛🧪 380,000 nuevos materiales creados con IA⋆ ༘🔬₊

- Importante avance en IA: Una carta, un algoritmo y el futuro de la humanidad

- 🤖🌟 ¡Tu IA Personalizada! Los GPTs de OpenAI han llegado

- 🔍 Forjando tu negocio con datos e IA

- Cómo aprenden los robots: Actualización y novedades 2023 con NVIDIA y Eureka

- Bienvenido a Mindful ML