Publicado

- 4 min tiempo de lectura

Semántica en la inteligencia artificial: word embeddings en NLP

¡Hola!

Feliz viernes 😊. Hoy quiero hablarte sobre algo que ha revolucionado el campo del Natural Language Processing (NLP): los word embeddings. Esta técnica ha llevado el NLP (Neural Language Processing) a un nivel completamente nuevo y lo mejor de todo es que puede tener aplicaciones increíbles para tu negocio. Vamos a verlo más a fondo 📈.

1. Introducción a los word embeddings

¿Te imaginas poder representar palabras de una manera que los algoritmos puedan entender su significado y sus relaciones contextuales? Eso es exactamente lo que hacen los word embeddings. Esta técnica convierte palabras en vectores numéricos de altas dimensiones (desde 768 hasta los 15,000 que dicen que maneja GPT-4) y, de esta manera, capturan tanto su significado como sus relaciones con otras palabras.

A diferencia de las tradicionales bolsas de palabras (bag of words), los word embeddings no solo superan sus limitaciones, sino que también mejoran el rendimiento de múltiples tareas en NLP, haciendo posibles nuevas aplicaciones.

Por ejemplo, un sistema de recomendación de películas puede volverse muchísimo más preciso gracias a estos vectores.

2. Cómo los word embeddings ayudan a los algoritmos

Los word embeddings capturan relaciones complejas entre palabras, como la similitud semántica y el contexto en el que se usan. Los algoritmos pueden aprovechar estas relaciones para ejecutar diversas tareas de NLP con mayor precisión y eficiencia.

Ejemplo: En traducción automática, un algoritmo puede entender que las palabras “rey” y “king” son equivalentes en distintos idiomas si están muy cercanas en el espacio de los embeddings. Esto facilita traducciones más precisas y una comprensión contextual más profunda.

3. Aplicaciones de word embeddings

Una de las ventajas más grandes de los word embeddings es que pueden ser entrenados incluso con conjuntos de datos relativamente pequeños, capturando aún así patrones y relaciones de manera efectiva. Esto los hace ideales para diversas aplicaciones, como el análisis de sentimientos, la extracción de información y la detección de spam.

Ejemplos:

- Análisis de sentimientos: Determinar si una reseña es positiva o negativa.

- Extracción de información: Identificar entidades mencionadas en textos, como nombres de personas o lugares.

- Detección de spam: Filtrar correos no deseados automáticamente.

4. La importancia de la desbiasificación

Una preocupación cada vez más extendida es que pueden aprenderse y perpetuarse sesgos presentes en los datos de entrenamiento. Y como los datos son parte de este mundo en el que vivimos, estos están llenos de sesgos discriminatorios para diferentes segmentos de la población. Esto puede llevar a decisiones injustas 💔.

Para evitarlo, se han desarrollado técnicas de desbiasificación, como la neutralización de vectores o la eliminación de direcciones discriminatorias.

Ejemplo: Utilizar word embeddings desbiased (ya sin sesgo) para evitar que un algoritmo de contratación discrimine por género, mejorando así la equidad en las decisiones.

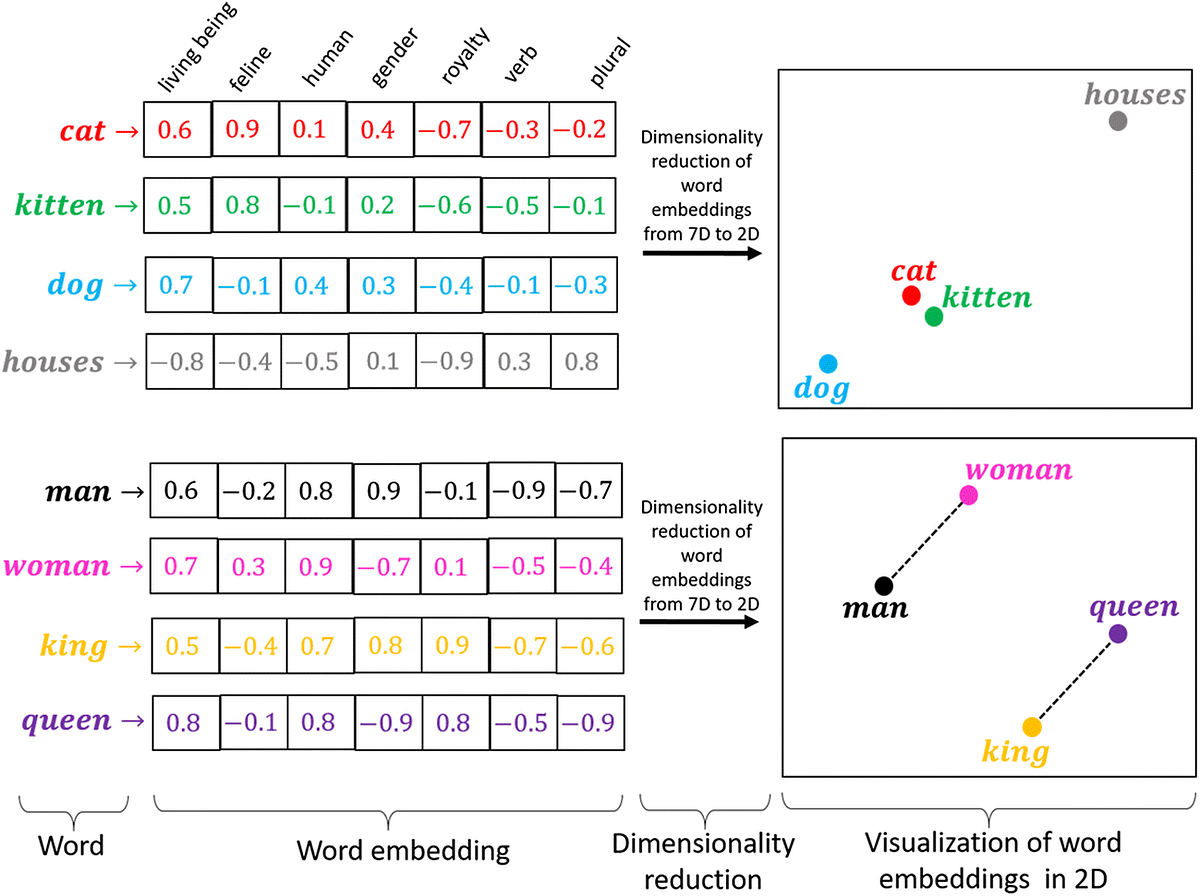

5. Representación de palabras como vectores

En esencia, los word embeddings representan palabras como vectores en un espacio de alta dimensión, donde cada dimensión captura una característica específica de la palabra, como su género o frecuencia de uso. Esta representación permite a los algoritmos identificar patrones y relaciones complejas de manera mucho más precisa.

Ejemplo: En la imagen inferior, los vectores capturan las siguientes características: living being (seres vivos), feline (si es un felino o no), human, gender (género), royalty, verb (si es un verbo) y si es plural.

La diferencia del valor numérico que hay dentro de cada celda nos indica lo cercanas en cuanto a semántica que están dos palabras con relación a una dimensión o característica.

6. Visualización de word embeddings

Para entender mejor los word embeddings, podemos visualizarlos en un espacio de baja dimensión utilizando técnicas como t-SNE o PCA. Como humanos, no podemos entender un espacio de 1024 dimensiones o más. Estas reducciones nos permiten ver cómo se agrupan palabras similares y cómo se separan palabras diferentes 🧩.

Ejemplo: Visualizar las relaciones entre palabras de un tema específico en un gráfico puede ayudarte a identificar agrupaciones y conexiones relevantes. En la imagen vemos un gráfico para la relación Male-Female (género), otro para Verb Tense (tiempo verbal), y Country-Capital (país y capital).

Como puedes ver, de esta forma es más sencillo entender que la dirección vectorial nos permite, partiendo de una palabra king, obtener queen, simplemente por comparación con el vector man-woman. Esta aproximación abre puertas impresionantes: las máquinas entienden semántica y contexto de esta forma.

7. La revolución de los word embeddings

Los word embeddings han revolucionado el campo del NLP a tal punto que no solo han mejorado significativamente el rendimiento de los algoritmos, sino que han facilitado el desarrollo de nuevas aplicaciones innovadoras.

Ejemplo: Los avances en traducción automática y la generación de texto más natural son solo el comienzo de lo que esta técnica puede lograr 💡.

Espero que este artículo te haya servido para entender lo que a diario nos bombardean los medios de comunicación con noticias impresionantes en este campo. ¿Tienes alguna idea en mente donde podrías aplicarlos? ¡Cuéntamelo!

Nos vemos la próxima semana, cada vez más cerca del futuro de la inteligencia artificial.

Artículos relacionados

SEO en la era de la IA: por qué ahora necesitas también GEO

Ahora tu agente inteligente te habla (y no interrumpe)

¿Qué hago primero hoy? Cómo prioriza el agente tus tareas

Ver 27 artículos más

- Cómo conectar tu agente con Notion y empezar a priorizar tu día

- Tu secretario inteligente: un agente que organiza tu día y te habla por Telegram

- Mejora tu IA con Generación Aumentada por Recuperación (RAG)

- Eventos del año: Google I/O 2024 y OpenAI Spring Update

- 🦙 LLaMA 3 ha llegado: Impulso para los Proyectos Open Source

- ¡A Freno Limpio! Tu Coche Pronto Leerá Tu Mente

- Google Cloud Next24: Google se suma a la carrera de los Agentes IA

- El Sesgo y la Varianza en el Machine Learning

- Redes Neuronales: Más Allá de los Fundamentos del Machine Learning

- 🤖 IA vs. Machine Learning vs. Deep Learning

- Explicabilidad vs. Interpretabilidad en IA

- Tendencias en Ciencia de Datos

- Batalla entre los Grandes Modelos de Lenguaje (LLM)

- La Magia del ML en los Pequeños Cultivos de la India

- Descubriendo el futuro: Una red neuronal que supera a los doctores 🏥✨

- Interpretabilidad vs. Explicabilidad: Desvelando el Enigma del Machine Learning

- ¿Software 2.0? ¡Descubre qué es! 🧑💻

- El futuro del ML es local, y va a revolucionarlo todo 📍

- La Revolución Antibiótica gracias a la Inteligencia Artificial

- 🚀 ¡Novedades IA: Gemini Pro y ChatGPT está perezoso! 🤖

- ¡El Competidor de ChatGPT ya está aquí! ¿Estás Listo para Gemini?

- ⚛🧪 380,000 nuevos materiales creados con IA⋆ ༘🔬₊

- Importante avance en IA: Una carta, un algoritmo y el futuro de la humanidad

- 🤖🌟 ¡Tu IA Personalizada! Los GPTs de OpenAI han llegado

- 🔍 Forjando tu negocio con datos e IA

- Cómo aprenden los robots: Actualización y novedades 2023 con NVIDIA y Eureka

- Bienvenido a Mindful ML